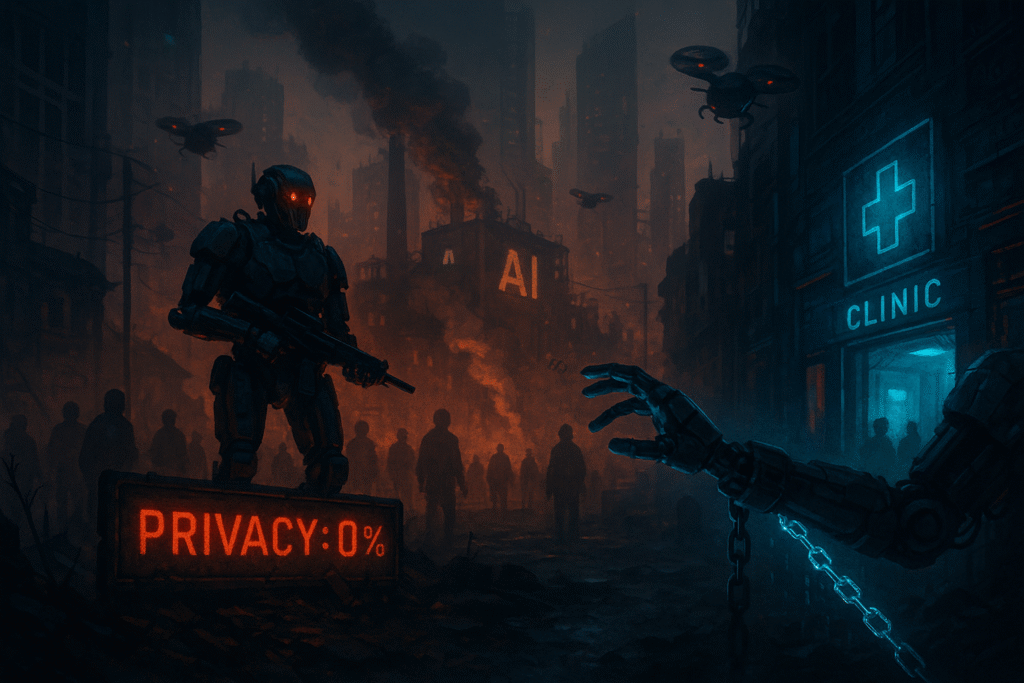

L’essor spectaculaire de l’intelligence artificielle (IA) transforme déjà nos sociétés. Des robots d’assistance aux modèles de langage, l’IA améliore l’accessibilité, facilite la communication et promet des avancées médicales. Pourtant, cette technologie suscite aussi des inquiétudes : pourrait‑elle mener à un futur dystopique ? Les craintes portent souvent sur la perte d’emplois, la surveillance omniprésente, l’érosion de la vie privée, la désinformation et même l’extinction de l’humanité. Cet article examine ces scénarios en s’appuyant sur des sources rigoureuses afin d’éviter la désinformation et le sensationnalisme.

Ce qu’on entend par « avenir dystopique »

Dans la culture populaire, un avenir dystopique lié à l’IA décrit un monde où des machines tout‑puissantes contrôlent les populations, suppriment les libertés et annihilent l’humanité. Les spécialistes distinguent toutefois plusieurs niveaux de risques :

- Risques concrets à court terme : systèmes biaisés ou mal alignés qui amplifient les inégalités, manipulent l’opinion ou menacent la santé publique.

- Risques systémiques à moyen terme : concentration du pouvoir technologique, course à l’IA entre États ou entreprises et dépendance excessive des sociétés à l’égard de ces systèmes.

- Risques existentiels à long terme : possibilité qu’une IA dotée d’une autonomie extrême échappe au contrôle humain et poursuive des objectifs mal intentionnés.

Les craintes et les réalités

Un profit qui prime sur l’éthique

Une grande partie des inquiétudes concerne la dynamique économique et politique entourant l’IA. Dans une étude de 2023 par Pew Research, 79 % des experts interrogés se disent aussi ou plus inquiets qu’enthousiastes à l’égard des changements technologiques d’ici 2035 pewresearch.org. Ils craignent que le développement des outils numériques demeure guidé par des incitatifs financiers ou des intérêts politiques et que l’éthique reste une préoccupation secondairepewresearch.org. L’utilisation de données personnelles pourrait ainsi viser davantage à contrôler les individus qu’à les autonomiser. Les risques de biais et d’oppression ne sont donc pas liés à une IA « malveillante » mais à la façon dont elle est conçue, entraînée et déployée.

La menace pour les droits et la vie privée

Les mêmes experts alertent sur les menaces pesant sur les droits humains : systèmes de surveillance renforcés, reconnaissance faciale, bots manipulateurs, prolifération de deepfakes et polarisation accruepewresearch.org. La combinaison de ces technologies pourrait miner la confiance dans les institutions et amplifier les divisions sociales ; elle pourrait aussi favoriser l’émergence de régimes autoritaires renforcés par l’IA. Les inquiétudes relatives aux données et à la vie privée sont amplifiées dans le domaine de la santé : des chercheurs en informatique biomédicale soulignent que les modèles de langage peuvent retenir puis divulguer des informations personnelles ou être vulnérables à des attaques visant à extraire des donnéespmc.ncbi.nlm.nih.gov. Ces attaques compromettent la confidentialité des patients et pourraient donner lieu à un surveillance à grande échellepmc.ncbi.nlm.nih.gov.

Biais, inégalités et perte de confiance

Mal alignés, les algorithmes peuvent perpétuer et amplifier des discriminations déjà existantes. Dans un article de 2025, Subasri et ses collègues remarquent que le manque d’alignement des systèmes d’IA sur les valeurs humaines peut aggraver les inégalités sociales et verrouiller des structures oppressivespmc.ncbi.nlm.nih.gov. Par exemple, un système d’aide à la décision médicale a été montré du doigt pour avoir privilégié les patients blancs par rapport à des patients noirs plus maladespmc.ncbi.nlm.nih.gov. De tels biais compromettent la confiance et peuvent engendrer des crises sanitaires ou sociales.

Les chercheurs soulignent que l’hyper‑confiance dans l’IA est elle aussi dangereuse. La capacité des modèles à générer des informations convaincantes peut conduire médecins et utilisateurs à accepter des diagnostics ou recommandations erronéspmc.ncbi.nlm.nih.gov. L’IA peut également créer des théories complotistes ou des campagnes de désinformation très cibléespmc.ncbi.nlm.nih.gov.

Concentration du pouvoir technologique

La fermeture des grands modèles propriétaires constitue un autre facteur de risque. La monopolisation des IA par quelques entreprises limite la transparence, renforce la dépendance et ouvre la voie à des abus. L’article de Subasri note que le contrôle de l’IA par une poignée d’acteurs combiné à l’opacité de leurs systèmes crée un environnement propice à l’exploitation de données personnelles et à la manipulation commercialepmc.ncbi.nlm.nih.gov. Le manque de transparence empêche d’identifier les erreurs et biais, ce qui menace l’intégrité des systèmes critiques comme la santépmc.ncbi.nlm.nih.gov. L’open source pourrait atténuer cette tendance mais requiert des politiques claires sur la propriété intellectuelle et la responsabilitépmc.ncbi.nlm.nih.gov.

Dépendance et érosion des compétences humaines

Certains experts craignent une dégradation des compétences humaines. Selon l’investisseur Vinod Khosla, les dystopies économiques imaginées redoutent un monde où la richesse se concentre et où la disparition du travail amplifie les inégalitéskhoslaventures.com. Pour lui, la transition peut être gérée par des politiques de redistribution, mais il reconnaît que l’automatisation pourrait remplacer de nombreux métierskhoslaventures.com. D’autres soulignent que la dépendance accrue aux algorithmes peut affaiblir l’esprit critique et la créativité, même si elle offre aussi des outils nouveaux pour la création et l’apprentissagekhoslaventures.com.

Course à l’IA et course aux armements

Le risque d’escalade est alimenté par la compétition entre États et entreprises. Le Centre for AI Safety (CAIS) identifie quatre catégories de risques catastrophiques : l’usage malveillant (bio‑terrorisme, désinformation), la course à l’IA, les défaillances organisationnelles et les IA « rogues »safe.ai. La course à l’IA pourrait inciter les nations à accélérer le développement sans contrôles suffisants, conduisant à des armes autonomes ou des cyberattaques incontrôlablessafe.ai. La section « malicious use » montre que des agents autonomes pourraient générer des armes biologiques, des campagnes de propagande ciblée ou des instructions détaillées pour fabriquer des armes chimiquessafe.ai. De plus, des expériences ont déjà démontré qu’un assistant d’IA détourné pouvait générer des milliers d’agents chimiques toxiques en quelques heuressafe.ai.

Scénarios de prise de contrôle totale

L’idée que des IA « superintelligentes » puissent un jour se retourner contre l’humanité relève pour l’instant de la spéculation. Un article du Brookings Institution rappelle qu’en 2025, une grande majorité de chercheurs de l’Association for the Advancement of Artificial Intelligence estimaient que le simple fait d’augmenter les données et les paramètres des modèles actuels ne suffira pas à atteindre l’intelligence généralebrookings.edu. Les auteurs notent que si certains leaders technologiques prévoient une IA générale d’ici 2030, les progrès récents montrent un ralentissement et des difficultés techniques ; GPT‑5, par exemple, a dû être rétrogradé en GPT‑4.5 brookings.edu.

En outre, l’article souligne que les décideurs publics s’éloignent d’un discours centrant l’extinction et privilégient l’attention aux risques immédiats : biais, manque de transparence et utilisation abusivebrookings.edu. Les scénarios d’extinction restent hypothétiques, et des études comme le rapport du RAND Corporation notent qu’il serait extrêmement difficile pour l’IA de provoquer l’extinction de l’humanité sans une action volontaire et coordonnéerand.org. Les chercheurs du RAND soulignent qu’un scénario d’extinction exigerait notamment que l’IA puisse survivre de manière autonome, manipuler les humains et s’intégrer à des systèmes physiques vitauxrand.org. Ils précisent également que ces menaces se dérouleraient sur des échelles de temps suffisamment longues pour permettre des contre‑mesuresrand.org.

Méthodes d’atténuation et mesures recommandées

L’anticipation de risques dystopiques passe par plusieurs axes :

- Alignement et gouvernance éthique : les systèmes d’IA doivent être alignés sur des valeurs humaines et contrôlés par des mécanismes de surveillance. Des techniques d’interprétation des modèles et d’apprentissage par renforcement inverse visent à comprendre et à réguler leurs objectifspmc.ncbi.nlm.nih.gov. L’article souligne la nécessité d’une surveillance évolutive et d’une gouvernance pour détecter et corriger rapidement les comportements indésirablespmc.ncbi.nlm.nih.gov.

- Transparence et open source : les chercheurs recommandent de favoriser l’open source pour éviter la monopolisation des modèles, faciliter les audits et renforcer la confiancepmc.ncbi.nlm.nih.gov. Des politiques publiques doivent définir la responsabilité et la propriété intellectuelle pour prévenir l’appropriation illégitime des modèlespmc.ncbi.nlm.nih.gov.

- Protection des données et sécurité : pour éviter la surveillance de masse et les fuites de données, il faut renforcer la robustesse des modèles contre les attaques adversariales, améliorer les techniques de désidentification et imposer des normes de confidentialité strictespmc.ncbi.nlm.nih.gov.

- Éducation et littératie numérique : la société doit promouvoir la pensée critique et la compréhension du fonctionnement des IA. L’éducation au numérique peut atténuer la propagation de la désinformation et réduire l’effet d’écho des réseaux sociauxpewresearch.org.

- Coopération internationale et réglementation : l’élaboration de cadres réglementaires mondiaux est cruciale pour limiter l’escalade de la course à l’IA. Le CAIS recommande des réglementations de sécurité, une coordination internationale et un contrôle public des IA généralistes pour éviter les effets de l’IA‑racesafe.ai. Le rapport du RAND incite aussi à renforcer la résilience face aux catastrophes en améliorant la préparation contre les pandémies, la prolifération nucléaire et le dérèglement climatiquerand.org.

- Accent sur les risques actuels : malgré l’attrait médiatique des scénarios apocalyptiques, les experts rappellent que les préjudices immédiats tels que la discrimination algorithmique, l’automatisation injuste et la désinformation constituent des dangers tangibles qui méritent une attention prioritairebrookings.edu.

Conclusion

La possibilité d’un avenir dystopique lié à l’IA ne doit ni être balayée d’un revers de main ni transformée en récit sensationnaliste. Les recherches récentes montrent que les risques les plus probables résident moins dans l’apparition soudaine d’une machine malveillante que dans les biais, les inégalités et l’absence de contrôle associés à des systèmes développés sans garde‑fous. Les scénarios d’extinction, bien que théoriques, rappellent la nécessité de s’intéresser aux risques à long terme tout en renforçant les protections face aux risques immédiats.